大數據之旅 Hadoop篇之HDFS 數據處理和存儲支持服務

在大數據技術的快速發展中,Hadoop生態系統憑借其強大的分布式處理能力,已成為處理海量數據的首選方案。其中,HDFS(Hadoop Distributed File System)作為Hadoop的核心組件之一,承擔著數據的分布式存儲和基礎處理支持服務。本文將深入探討HDFS在數據處理和存儲方面的關鍵作用,幫助讀者理解其在現代大數據架構中的重要性。

一、HDFS概述

HDFS是一個高度容錯、可擴展的分布式文件系統,專門設計用于運行在商用硬件上,處理大規模數據集。它采用了主從架構,包括NameNode(主節點)和DataNode(從節點)。NameNode負責管理文件系統的命名空間和客戶端訪問,而DataNode存儲實際的數據塊。HDFS的核心目標是提供高吞吐量的數據訪問,支持數據密集型應用。

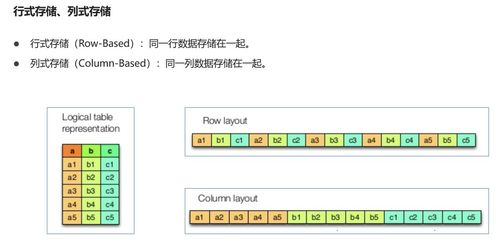

二、HDFS的數據存儲機制

HDFS通過將大文件分割成固定大小的數據塊(通常為128MB或256MB),并將這些塊分布存儲在不同的DataNode上,實現數據的分布式存儲。這種設計不僅提高了數據的可靠性(通過副本機制,默認每個塊有3個副本存儲在不同節點上),還優化了并行處理效率。例如,在MapReduce作業中,計算任務可以直接在存儲數據的節點上執行,減少了網絡傳輸開銷。

三、HDFS的數據處理支持服務

除了存儲功能,HDFS為數據處理提供了基礎支持服務。它通過數據本地性優化,確保計算任務優先在數據所在的節點上運行,從而加速處理速度。HDFS的API支持多種數據讀寫操作,包括追加寫入和流式讀取,適用于批處理和實時分析場景。工具如HDFS CLI和WebHDFS進一步簡化了數據管理,允許用戶上傳、下載和監控文件。

四、HDFS的優勢與挑戰

HDFS的主要優勢在于其高可靠性、可擴展性和成本效益。它能夠處理PB級別的數據,并自動處理節點故障。HDFS也存在一些挑戰,例如不適合低延遲的隨機讀寫,且對小文件的支持效率較低。針對這些問題,Hadoop社區通過引入如HDFS Federation和Erasure Coding等技術進行優化。

五、實際應用場景

HDFS廣泛應用于各種大數據場景,如日志分析、數據倉庫和機器學習。例如,在電商平臺中,HDFS可以存儲用戶行為日志,支持后續的推薦系統分析。結合其他Hadoop組件如MapReduce或Spark,HDFS構建了完整的數據處理流水線。

六、總結與展望

HDFS作為Hadoop生態的基石,為大數據處理提供了可靠的存儲和處理支持服務。隨著技術的演進,HDFS正不斷融入云原生和AI驅動的新特性,未來將繼續在大數據領域發揮關鍵作用。對于初學者而言,掌握HDFS是開啟大數據之旅的重要一步,建議通過實踐部署和操作來加深理解。

如若轉載,請注明出處:http://m.9962333.com/product/10.html

更新時間:2026-02-20 02:41:58